드론 기반 딥러닝을 활용한 교차로 교통 데이터 분석

Crossroads Traffic Data Analysis Using Drone-Based Deep Learning

Article information

Abstract

본 연구에서는 드론을 활용한 도로 교통 데이터 수집 및 딥러닝 기반 분석을 통해 교통 상황을 모니터링하는 방법을 제안하였다. YOLOv8 객체 탐지 모델을 활용하여 45도와 90도 촬영한 교차로 교통 영상을 분석하고, 촬영 각도에 따른 객체 탐지 능력 차이를 확인하였다. 객체 추적 시 발생하는 폐색 영역 문제를 해결하기 위해 촬영 각도를 최적화하고, 최종 모델을 통해 평균 96.9%의 경로 인식률과 93.7%의 차종 인식률을 달성하였다. 이를 통해 드론 기반의 교통 데이터 수집 및 딥러닝 분석이 도로 교통 관리에 효과적으로 활용될 수 있음을 입증하였다. 향후 더 정교한 교통 정보 시스템의 개발과 활용에 대한 연구가 필요하다.

Trans Abstract

This study proposes a method for monitoring traffic conditions via the collection of road traffic data using drones and deep learning-based analysis. Utilizing the YOLOv8 object detection model, we analyzed traffic videos captured at 45 and 90 degrees at intersections, which revealed differences in object detection capabilities based on the shooting angle. To address issues related to occluded areas during object tracking, we optimized the shooting angles, and achieved a final model with an average of 96.9% and 93.7% path and vehicle type recognition rate, respectively. This validates the effective utilization of drone-based traffic data collection and deep learning analysis in road traffic management. Further research is necessary for the development and application of more sophisticated traffic information systems in the future.

1. 서 론

최근 교통정보는 이동을 중심으로 하는 현대 사회에서 필수적인 정보로 자리 잡고 있다. 특히, 전기차의 보급과 함께 자율주행 기술이 발전하면서 실시간 정보제공의 수요는 더욱 증가하고 있으며, 교통정보센터를 중심으로 정보의 수집, 가공, 그리고 제공이 이루어지고 있다. 현재 교통정보 수집 방식은 주로 인력⋅검지기식으로 수집하고 있으며, 이에 따라 돌발상황이나 긴급 상황에 신속한 대응하지 못하는 상황이 발생하고 있다.

현재 교통정보 수집은 교통정보센터에서 실시간 교통정보를 수집하고 관리하고 있다. 교통정보센터에서는 Fig. 1에 보이는 것과 같이 도로의 소통 현황 및 교차로의 Level of Service (LOS), 시간대별 도로의 속도 통계정보를 제공하고, 이를 기반으로 교통신호 시스템을 운영하고 있다.

이러한 지점 검지기 교통 데이터를 기반으로 하는 시스템은 검지기 위치를 중심으로 한 정보만을 제공하며, 검지기 수를 늘리면 더 정확한 자료를 수집할 수 있으나, 설치비 및 유지관리 비용 상승으로 인해 현실적으로 이루어지기 어려운 실정이다. 또한, 현행 교통관리 시스템은 지점 검지기 데이터를 기반으로 하며, 이에 따라 복잡하고 다양한 원인으로 발생하는 교통혼잡을 근본적으로 이해하고 대응하는 데 한계가 있으며, 교통혼잡 완화를 위한 다양한 교통관리 기법을 도입하는 데도 어려움이 있다.

드론 기술의 발전은 도로 상황의 촬영과 분석에 새로운 가능성을 제시하고 있다. 높은 해상도의 영상 데이터를 획득할 수 있어 도로 전반의 교통 상황을 실시간으로 입체적으로 파악할 수 있으며, 교통 데이터의 정확성과 포괄성을 향상할 수 있다. 지점 검지기의 한계를 극복하고 향후 자율협력 주행 시대에 필요한 새로운 교통 데이터를 수집할 수 있는 수단으로 드론 영상 촬영이 대두되고 있다.

지점 검지기 기반의 단점을 극복할 수 있는 드론 영상 기반 차량 궤적 데이터 분석을 통해 도로의 교통 상태를 추정하고 변화과정을 분석하여 혼잡 발생과 전이 과정을 도로 이용자에게 제공하는 것이 필요하다.

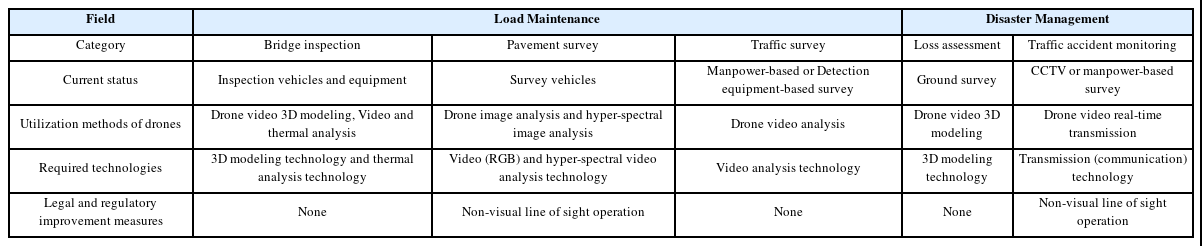

도로 교통 사업 분야의 드론 활용 현황 조사 결과, Table 1에 보이는 것과 같이 도로의 유지관리 및 재난 관리 과정에서 드론이 활용 가능하다는 것이 확인되었다. 또한 최근 교통조사에 기존의 인력이나 검지기를 활용한 조사가 아닌 드론 영상을 통한 자동 추출하여 활용할 수 있는 연구가 진행되고 있다.

Seo and Lee (2018)는 드론을 활용한 교통정보 관련 연구는 비용 절감 효과, 차량 주행 궤적 추출, 딜레마 구간 안전 개선, 도로 및 차량 검지 등이 있으며, 최근에는 교통정보 추출 및 분석 방법론에 관한 것도 가능하다고 하였다. 그리고 Jang et al. (2022)은 객체 인식 모델을 사용한 교통 데이터수집 기법이 개발되어 있으며, 드론 영상을 통해 교통 데이터를 추출하는 연구가 진행 중이다. 그러나 수집된 교통 데이터를 다양한 분야에서 활용하도록 분석 및 가공하는 연구가 더 필요하다고 하였다.

Lim et al. (2019)는 드론 영상종합정보 처리 및 분석용 시스템을 소개하며, 이 시스템이 다양한 재난, 치안, 안전 임무 상황에서 적용될 수 있다고 제안하였으며, 이 시스템은 교통량 측정, 용의자와 차량 추적, 조난자 식별 및 해상 초계 임무 등 다양한 용도에 활용될 수 있음을 확인하였다.

Lee et al. (2020)은 교통정보 수집에 사용되는 다양한 수집 장비에 대해 검토하고 해당 장비의 운용 상황과 문제점을 분석하였다. 그리고 이를 토대로 기존 교통정보 수집 방식의 문제와 오차를 감소시키기 위해 드론을 활용한 교통 영상 정보 수집 방법을 제안하였다.

Han and Lee (2021)은 드론 영상이 교통 시스템에 유용하게 활용될 수 있다는 것은 확인되었으나, 자율주행 차량에 효과적인 교통정보 제공 시스템은 아직 미비한 상태라고 하였다. 또한 Jung et al. (2021)은 자율주행차에 탑재된 ADAS 장비의 시공간 정보를 통해 동적 교통정보를 수집하고 중앙집중식 자율주행차 모빌리티 서비스를 개발한 연구가 있으며, VIS SIM을 활용한 서비스 평가 결과, 자율주행차의 경로 변경이 통행시간을 단축하는 효과가 있었으나 동적 교통정보를 자율주행차로부터 획득하는 데는 한계가 있다고 하였다.

Kim et al. (2022)는 차량의 블랙박스 영상과 차량의 사고기록장치를 통하여 영상으로 구현한 차량의 거동을 분석하여 사고의 원인을 분석하는 연구를 수행하였다.

Choi (2022)는 지상 교통관제 시스템으로 활용될 수 있는 드론을 사용하여 실시간 연산 가능성을 확보하고 능동적 판단이 가능한 시스템을 구축하기 위해 딥러닝 객체 탐지 알고리즘 YOLO를 적용한 보행자와 차량의 실시간 탐지 및 추돌 경고 시스템을 제안하였다.

Alotaibi et al. (2022)는 무인 항공기(UAV)는 스마트 시티에서 여러 목적에 활용할 수 있는 모바일 장비이며, 교통 관찰, 환경 모니터링, 공공 안전에 활용할 수 있다. 또한, 드론 기반 증거 수집이 필요한 경우 디지털 증거의 무결성을 보존하기 위한 적절한 수집 및 분석 방법과 도구를 사용해야 한다고 하였으며, Abdullah et al. (2022)는 교통 분석을 위한 드론 영상 촬영에 관해서 기존 1시간 자료수집의 대안으로 드론 영상 15분 자료수집의 신뢰성에 관한 연구를 통해 교통혼잡 시간대의 15분 자료수집이 교차로 성능 분석을 쉽게 할 수 있다는 것을 보여주었다.

이전까지의 선행연구들은 드론을 활용한 교통 연구가 유용하다는 점을 확인하였지만, 교통정보 수집 및 분석에 직접적으로 관련된 연구는 미미한 수준으로 파악되었다. 본 연구는 선행연구들의 아이디어를 기반으로 드론의 한계를 최소화하고 교통밀도 정보 수집에 초점을 두어 차별성을 부여하고자 한다. 그리고 드론을 활용하여 정확하고 포괄적인 교통 자료를 수집하고, 이를 분석하여 도로 상황을 파악하여, 교통 혼잡도를 예측하는 방법을 개발하고자 한다.

2. 연구 대상 구간 선정 및 데이터 수집

2.1 연구 대상

본 연구에서 분석하고자 하는 도시의 도로 현황은 Table 2에 보이는 것과 같으며, 연구 대상의 교차로 중 교통량이 많고 차로가 다양한 구간을 대상으로 선정하였다. 이 대상 구간은 드론 비행 및 촬영이 허가된 지역으로 한정하였으며, 11개소를 대상으로 하였다. 또한, 시간적 범위는 기상 조건 등을 고려하여 4개월 동안 진행되었으며, 관련 법적 규정을 준수하여 드론 촬영이 가능한 조건에서 수집하였다.

2.2 현장 조사

교통 영상을 분석하기 위해 6개 차종의 통행량 분포비를 고려하여 연구 대상 주변 교차로를 Table 3에 보이는 것과 같이 조사지역으로 선정하고, 드론 영상을 20회 촬영하였다. 여기서, B, C, D 교차로의 경우 촬영 각도별 인식률 비교를 위해 Fig. 2(a)의 촬영 각도 90도와 Fig. 2(b)의 45도로 나누어 촬영하였다. 90도 각도는 교차로 정중앙 위치하여 고도 100 m, 45도 각도는 교차로 측면에 위치하여 고도 50~60 m로 비행하여 영상을 수집하였다. 조사지역의 건물 높이와 주변 지형지물을 고려하여 교차로 고도를 선정하였다.

2.3 조사 영상 차종분류

본 연구의 현장 조사 결과를 바탕으로 영상을 분석하고 딥러닝 알고리즘을 구현하기 위해 현재 교차로 서비스수준 분석에 사용 중인 6종의 차종분류를 적용하였다. 차종분류는 도로용량편람(Ministry of Land, Infrastructure and Transport, 2013)의 6종인 승용차, 버스(소), 버스(대), 트럭(소), 트럭(중), 트럭(대)으로 분류하였다.

3. YOLO를 활용한 차량 객체, 주행 경로 모니터링

드론으로 촬영한 교통 영상을 차종 분류 및 차량 주행 경로 도출을 위해 다음과 같이 영상 내 개별 프레임에서 차량을 검출하고 추적하는 과정을 딥러닝 모델과 추적 알고리즘을 활용하여 수행하였다. YOLOv8의 주요 객체 해석 과정은 차량 검출 및 분류, 차량 객체 추적 그리고 데이터 세트 구축으로 나누었다.

차량 검출 및 분류는 YOLOv8 객체 탐지모델을 사용하여 각 프레임에서 차량을 검출하고 차종은 Table 5에 보이는 것과 같이 총 6가지로 분류하였다.

차량 객체 추적은 Byte Track 객체 추적 알고리즘을 활용하여 각 차량 객체를 프레임 간에 추적할 수 있도록 하였다. 이를 통해 차량의 이동 경로 및 주행 궤적을 도출하며 총 12가지의 주행 궤적으로 분류하며, 수집된 영상의 차량 객체의 동적인 이동을 자동으로 집계하였다.

데이터 세트 구축은 객체 탐지 및 분류를 위해 YOLOv8 모델을 훈련하기 위해 정제된 데이터 세트가 필요하다. 따라서 차종 구분을 위해 교차로 교통량 촬영 영상을 활용하여 데이터 세트를 제작하고, 데이터 세트는 사거리 중앙 촬영, 사거리 외곽 촬영, 두 영상을 혼용하여 총 3가지로 구성하였다.

3.1 객체 탐지모델 선정

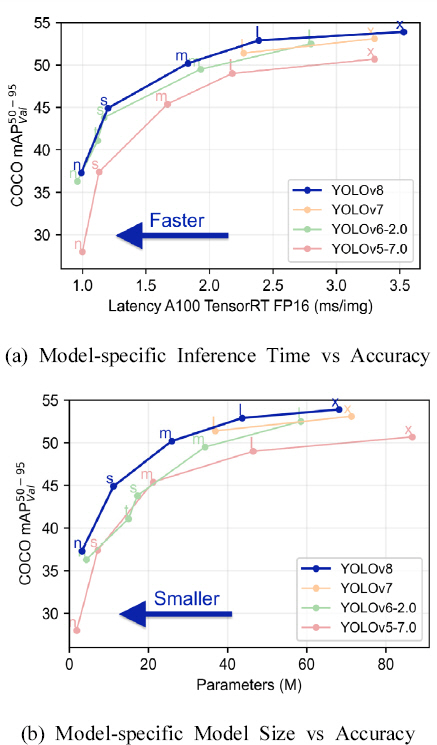

영상 속 차량의 종류를 구별하고 추적하기 위해서는 객체 탐지와 객체 추적이 필요하다. 객체 추적 작업은 객체 탐지에서부터 시작된다. 객체 탐지를 위한 모델로 YOLO (You Only Look Once) 모델 중 가장 최신 모델인 YOLOv8 모델을 선택하였다. YOLOv8은 2023년에 출시된 YOLO 모델이며 Fig. 4에 보이는 것과 같이 이전 버전에 비하여 성능이 향상된 것을 확인하였다.

3.2 객체 추적 알고리즘 선정

객체 추적 알고리즘은 영상의 t1, t2 프레임에서 객체를 탐지하고 t1에서 탐지된 객체와 t2에서 탐지된 객체가 유사한지 판단하여 t1의 객체가 t2의 객체와 유사하다면 두 객체는 같은 객체로 보고 t1의 객체가 t2에서 새로운 위치로 이동했다고 판단한다. 본 연구에서는 객체 추적 알고리즘으로 Byte Track을 사용하였다. Byte Track 알고리즘은 기존의 Multi- bject tracking 접근법을 개선하기 위한 알고리즘으로 SORT (Simple Online and Realtime Tracking) 알고리즘보다 개선된 성능을 제시하여 이를 채택하였다.

3.3 경로 검출 알고리즘

경로 검출 알고리즘은 Fig. 5에 보이는 것과 같이 사용자가 차량의 경로를 검출하고 싶은 사거리 촬영 영상을 입력으로 넣으면 영상의 첫 프레임을 화면에 띄워 사용자가 영상 속 4개 도로에 감지 영역을 직접 지정한다. 영상에서 영역을 지나간 차량을 전부 기록하고 사용자는 감지 영역을 지정할 때 점 4개를 찍어서 사각형 형태로 지정한다.

3.3.1 프로그램의 동작 과정

3.3.1.1 사용자 정의 감지 영역

입력으로 받는 영상의 촬영 각도 및 높이에 따라 도로의 길이와 폭이 달라지므로, 고정된 감지 영역보다는 사용자가 직접 각 영상에 맞는 영역을 지정하는 것이 더 적합하다고 판단하여 채택하였다.

3.3.1.2 Byte Track 알고리즘을 활용한 객체 추적

Byte Track 알고리즘으로 각 프레임에서 객체의 위치를 추적하고, 객체가 감지 영역을 지나가면 해당 객체의 ID, 차종 ID, 감지 영역의 위치를 추출하여 데이터프레임에 저장한다.

3.3.1.3 데이터프레임 가공 및 경로 추출

영상 속 차량의 객체 추적이 끝나면, 데이터프레임에 쌓인 차량 정보들을 가공하여 경로를 얻는다. 처음에 잠시 틀린 차종으로 분류된 경우, 해당 객체의 차종 ID를 가장 빈도수가 높은 ID로 치환하여 정보를 보정한다.

3.3.1.4 중복 값 제거를 통한 정확한 추적 정보 추출

객체 ID와 감지 영역의 위치를 기준으로 중복 값을 전부 제거한다. 중복 값을 제거하면 각각의 감지 영역을 지나간 객체의 ID와 차종 ID를 얻을 수 있게 된다.

3.3.1.5 한 감지 영역을 지난 객체 정보 추출

같은 객체 ID가 중복된 행만 남기고 나머지는 삭제하여 두 개의 감지 영역을 지난 객체 ID만을 보존한다. 이 과정을 통해 한 감지 영역에서 감지가 되었지만, 후속 감지 영역으로 향할 때 추적이 끊기고 다른 객체 ID를 부여받는 경우, 해당 객체의 정보를 제거할 수 있다.

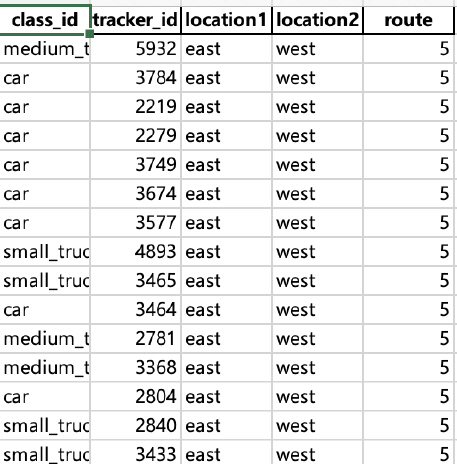

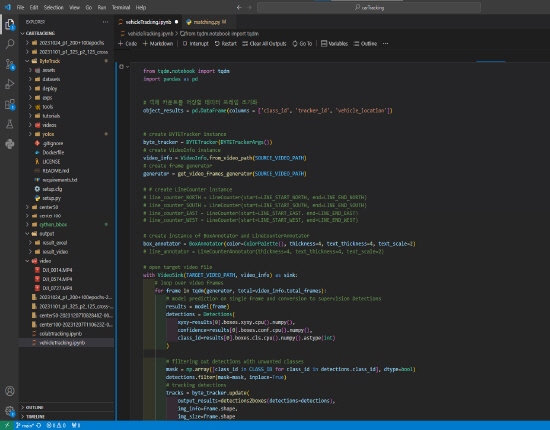

결과적으로, 이러한 과정을 통해 두 개의 감지 영역을 지난 객체들의 정보를 얻고, 각 객체가 지나간 감지 영역을 통해 해당 객체가 사거리에서 어느 경로로 이동했는지를 추출할 수 있다. 경로 검출의 결과물은 Fig. 6에 보이는 양식의 엑셀 파일로 반환받는다. Fig. 7는 본 연구에서 사용한 교차로 교통량 객체 및 경로 인식 모델 프로그램의 스크립트를 나타내었다.

4. 차량 객체 및 주행 경로 모니터링 결과

4.1 교차로 교통량 촬영 조건별 탐지율 비교 결과

경로 검출 작업 이전에 객체 탐지모델인 YOLOv8을 사용하여 상공에서 촬영한 사거리 교통 영상에 대한 객체 탐지를 수행하였다. YOLOv8는 COCO dataset으로 기본적으로 pretraining이 되어있는 모델로, car, truck, bus를 포함한 80가지 클래스에 대한 객체 탐지를 수행할 수 있는 모델이다. 영상의 촬영은 교차로 상부 45도와 90도 각도로 진행하여 상호 비교하였다.

4.1.1 각도에 따른 객체 탐지 능력 차이

4.1.1.1 45도 촬영 영상에서의 특징

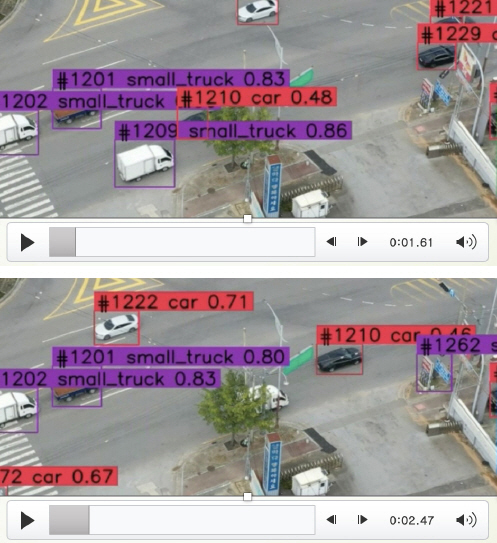

Fig. 8에 보이는 것과 같이 45도 촬영 영상에서는 다수의 차량 클래스를 성공적으로 탐지했다. 이는 차량의 윗면 및 옆면이 촬영되어 객체 탐지모델이 해당 개체를 차량으로 식별하기에, 충분한 근거를 제공할 수 있다.

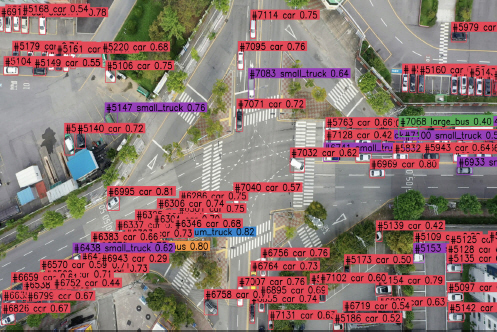

4.1.1.2 90도 촬영 영상에서의 어려움

Fig. 9에 보이는 것과 같이 90도 촬영 영상에서의 차량 객체의 탐지 능력이 45도 촬영 영상과 비교하여 심하게 떨어지는 것을 알 수 있다. 이는 대부분 차량의 윗면만이 촬영되어 있어, 45도 각도 영상보다 객체 탐지가 어렵다는 결과로 판단된다.

4.1.1.3 분석 데이터 세트의 한계점

45도 각도에서 촬영한 사거리 영상은 90도 촬영 영상보다 객체 탐지에 유리하나, Fig. 10에 보이는 것과 같이 45도 각도 영상에서도 사물에 객체가 가려지면 인식률이 떨어지는 명확한 한계점이 발견되었다.

4.1.2 객체 추적 시 발생하는 폐색 영역 분석과 촬영 각도 선택

4.1.2.1 폐색 영역 발생원인

객체 추적 과정에서 차량이 도로상의 가로수 등의 장애물을 지나면서 가려지는 폐색 영역이 발생한다. 이에 따라 객체 추적이 일시적으로 끊기고, 경로 인식률이 저하되는 문제가 발생한다.

4.1.2.2 적치물과 차량에 의한 폐색 영역

한 차선에 대형트럭이나 버스가 지나가면서 옆 차선의 차량을 가리거나, 도로 옆의 가로수나 전봇대를 가리는 등의 상황에 따라 인식률이 다르게 변한다.

4.1.2.3 촬영 각도

45도 각도로 촬영한 영상은 적치물이나 차량에 의해 가려지는 폐색 영역이 자주 발생하므로 경로 검출에 한계가 있다. 반면, 90도 촬영 영상은 폐색 영역이 적고, 객체 추적에 미치는 영향이 적어 경로 검출에 더욱 적합하다. 45도 촬영 각도에서는 수시로 객체의 부분 또는 전체가 가려지는 경우가 빈번하게 발생한다. 90도 촬영 각도에서는 폐색 영역이 적고, 객체 추적에 영향을 덜 받기 때문에 경로 검출에 명확한 결과를 얻을 수 있다. 따라서 폐색 영역의 발생 확률이 낮은 90도 촬영 영상을 경로 검출의 촬영 각도로 선택함으로써 폐색 영역의 발생 확률을 낮추고, 객체 추적에 미치는 영향을 최소화하였다.

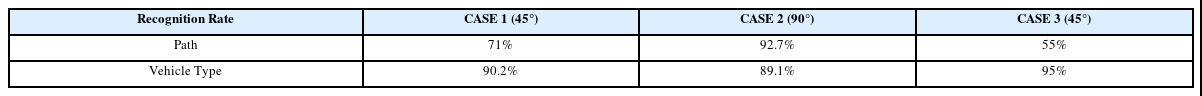

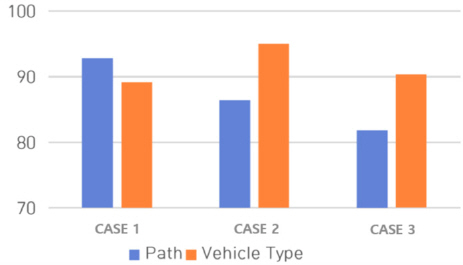

Table 6에 최초 모델의 촬영 각도에 따른 경로 및 차량 인식률을 나타내었다. 여기서 Fig. 11에 보이는 것과 같이 CASE 1 및 2는 교차로 출구에 위치하며, CASE 3은 교차로 중앙에 위치한다.

4.2 드론 영상 교통 데이터의 인식률 고도화

드론의 교통 데이터 인식률 고도화를 위해 촬영 각도를 확인하였으며 이를 통해 교차로 중심부에서 90도 촬영 시 객체의 인식 및 경로 인식률이 높아짐을 확인하였다. 교차로 중앙부 촬영 영상을 딥러닝 기반으로 훈련 시켰으며, 1차 모델 및 2차 모델을 통해 인식률을 증가시켰다.

4.2.1 1차 모델 인식률

1차 모델 인식 결과 Fig. 11과 같이 나타났으며, 이를 Table 7과 Fig. 12에 정리하였다. 그 결과 경로의 인식이 81.8%에서 92.8%로 나타났으며, 차종의 인식률은 89.1%에서 90.3%로 나타났다.

5. 결 론

본 연구는 기존의 교통량 조사 방법에 대안으로 드론을 활용한 영상 촬영 및 분석을 도입하여 시행되었습니다. 주요 연구 결론은 다음과 같다.

45도 각도의 데이터 세트는 폐색 영역 문제로 경로 검출에 한계를 가지고 있었다. 따라서 90도 각도의 데이터 세트를 활용하여 폐색 영역의 발생 확률을 낮추고 객체 추적에 미치는 영향을 최소화하였으며, 90도 각도의 데이터 세트를 중심부와 외곽을 구분하여 인식률을 높이기 위한 상호 비교를 수행하였다.

본 연구에서 개발된 객체 및 경로 인식 모델을 사용하여 수행한 경로 검출 결과를 확인한 결과, 45도 각도 촬영 영상 두 개와 90도 각도 촬영 영상 하나로 경로 인식률을 평가한 결과, 45도 각도 촬영 영상이 90도 각도 촬영 영상과 비교하면 경로 인식률이 크게 떨어지는 것을 확인하였다.

영상 분석 결과에서 가로수, 전봇대 등의 장애물이 차량 객체를 가리면서 객체 탐지가 끊기는 것이 경로 인식률 하락의 주요 원인임을 확인할 수 있었다.

경로 인식률 개선을 위해 현재 90도 각도에서 사거리 중앙을 촬영한 영상과 외곽을 촬영한 영상을 분류하여 새로운 데이터 세트를 제작하고 분석하였으며, 차종별 인식률은 평균 93.7%, 경로 인식률은 평균 93.7%로 향상된 모델을 개발함을 확인하였다.

본 연구는 드론을 활용한 교통량 영상 촬영 및 딥러닝 기반 드론 영상 교통 데이터 분석을 수행했으며, 향후 교통혼잡 완화 및 자율주행 시스템에 적용할 수 있는 도구 개발이 추가로 부가되어야 할 것이다.

감사의 글

본 과제(결과물)는 2023년도 교육부의 재원으로 한국연구재단의 지원을 받아 수행된 지자체-대학 협력 기반 지역혁신 사업(2021 RIS-002)의 결과입니다.